Искусственный интеллект все активнее используется в академической среде – от подготовки текстов к анализу научных источников. Для многих исследователей это выглядит как логический шаг к оптимизации научных трудов и уменьшению нагрузки.

Однако автоматизация текста не равна автоматизации научного исследования. В этой статье рассматривается, почему сгенерированный ИИ текст не может заменить полноценную научную работу, а также какие методологические риски возникают при некритическом использовании алгоритмов.

Современная научная деятельность функционирует в условиях постоянной перегрузки: возрастающие требования к количеству публикаций, работа с реферированными изданиями, дедлайн и административное давление. В этом контексте ИИ рассматривается как инструмент, способный рационализировать процесс написания научных текстов.

Однако научная ценность определяется не скоростью создания текста, а эпистемологической ценностью – способом получения знания, обоснованностью методов и способностью автора отвечать за сделанные выводы. Именно это и лежит в основе критического анализа использования ИИ в науке.

ИИ может воспроизводить структуру научной речи, но она не участвует в процессе формирования знания. Именно поэтому то, что выглядит как оптимизация, часто является упрощением, которое смещает фокус из исследования на его внешнюю репрезентацию.

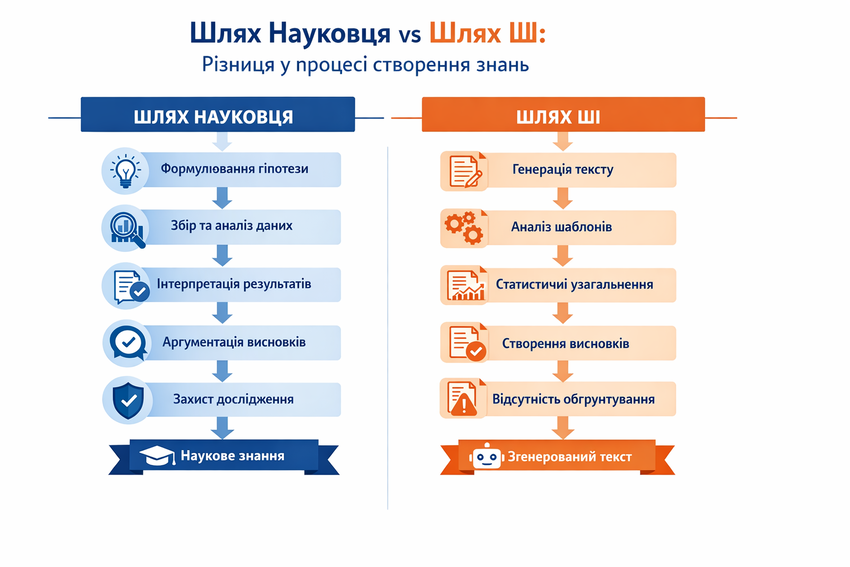

Наиболее существенный риск использования ИИ в науке заключается в замене исследовательского процесса текстовой имитацией. В таких случаях научная работа начинает восприниматься как продукт, который можно собрать с корректных формулировок, а не как результат длительного аналитического пути.

Эта подмена особенно опасна с методологической точки зрения. Текст, созданный или в значительной степени сформированный алгоритмом, может выглядеть логически упорядоченным, но при этом не иметь внутренней связи между:

В результате возникает ситуация, когда форма исследования сохранена, но его эпистемологическая ценность существенно понижена или отсутствует вообще. Такой текст не продуцирует новое знание и не выдерживает критического анализа, даже если формально отвечает требованиям к структуре научной работы.

Именно поэтому автоматизация в науке становится проблемой не тогда, когда используется как инструмент, а когда начинает заменять исследование его текстовым отображением. В этом случае научная деятельность редуцируется к риторике, а не познанию, что принципиально неприемлемо для академической среды.

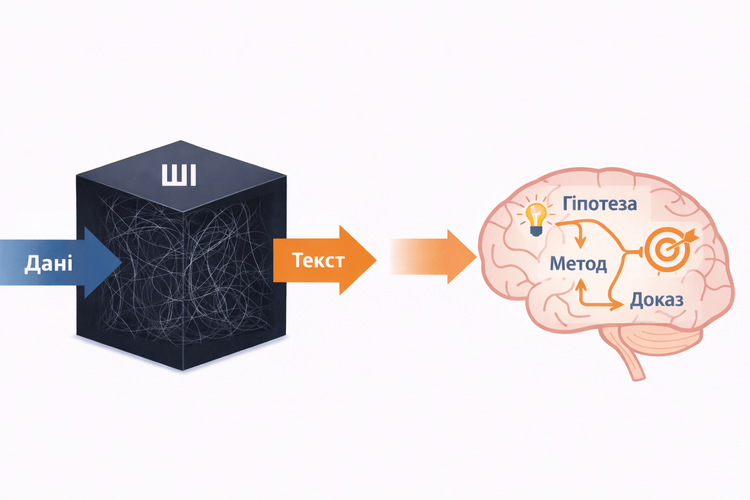

В контексте научного познания ключевой проблемой использования искусственного интеллекта есть проблема «черного ящика». Под этим термином в науке понимается ситуация, когда результат получен, но путь его формирования невозможно прозрачно реконструировать. Для научного исследования это критично, ведь принцип воспроизводимости предполагает возможность объяснить, при каких условиях и на основе каких процедур были сделаны выводы.

Практические последствия проблемы черного ящика становятся особенно очевидными на этапе защиты диссертации. В ходе научной дискуссии оппонент или член специализированного совета может задать, на первый взгляд, простой вопрос: «Почему вы выбрали именно этот статистический критерий или метод анализа?»

Если методологический раздел был сгенерирован или дополнен искусственным интеллектом, автор часто не способен воспроизвести логику этого выбора. В таком случае становится очевидным, что решение не есть результат собственного исследовательского мышления. Это приводит к быстрому разрушению всей научной конструкции: от методологии – к выводам.

Именно поэтому в контексте написания диссертации без ИИ прозрачность метода и личное понимание каждого этапа исследования не формальное требование, а критическое условие успешной защиты.

ИИ, в отличие от исследователя, не оперирует методологическими решениями в классическом научном смысле. Его ответы являются результатом статистического сопоставления языковых паттернов, а не последовательного исследовательского процесса. В результате возникает методологический разрыв между формально полученным текстом и его эпистемологической ценностью.

Ключевые методологические отличия между исследованием и ИИ-генерацией

|

Критерий |

Научное исследование |

Текст, созданный ИИ |

|

Прозрачность метода |

Метод описывается и может быть воспроизведен |

Путь получения результата непрозрачен |

|

Воспроизводимость |

Другие исследователи могут проверить результат |

Повторение не гарантирует тождественных выводов |

|

Исследовательский путь |

Содержит сомнения, коррекции, уточнения |

Отсутствует как процесс |

|

Эпистемологическая ценность |

Формируется через анализ и проверку |

Не формируется, только имитируется |

Эти отличия объясняют, почему тексты, созданные ИИ, часто выглядят методологически корректными, но не выдерживают более глубокой экспертной оценки.

Одним из наиболее типичных признаков ШИ-текстов является формальное копирование научных шаблонов. Алгоритм хорошо воспроизводит структуру статьи или диссертации, типовые формулировки и стандартные переходы между разделами. Однако это соответствие носит декларативный характер.

Вместо реального обоснования выбора методов или анализа альтернатив, ИИ предлагает обобщенные формулы, которые выглядят нейтрально и безопасно. В таких текстах обычно не хватает:

Для рецензента это сигнал того, что методология была описана, но не применена.

Еще одной методологической ловушкой является имитация аналитической глубины. ИИ способен создавать тексты, насыщенные терминами и обобщениями, которые на первый взгляд производят впечатление сложного анализа. Однако за этой речевой сложностью часто не стоит реальная работа с эмпирическими данными.

В научном исследовании глубина определяется не стилистической сложностью, а:

Когда эти элементы заменяются текстовой имитацией, исследование теряет свою научную сущность. Именно здесь проблема «черного ящика» проявляется остро: если невозможно объяснить, как именно получен вывод, такой результат не может считаться методологически валидным — независимо от качества изложения.

Одной из принципиальных проблем использования искусственного интеллекта в научных исследованиях есть алгоритмическое предубеждение (algorithmic bias).

Алгоритмическое предупреждение (algorithmic bias) — систематическое искажение результатов, возникающее тогда, когда алгоритмы искусственного интеллекта воспроизводят или усиливают перекосы, уже имеющиеся в данных, на которых они были обучены. Такие перекосы могут носить культурный, социальный, гендерный или научно-методологический характер и не являются результатом сознательного выбора, а следствием статистической природы обучения моделей.

В частности, речь идет о западноцентрических интерпретациях, доминировании определенных научных школ или воспроизводстве гендерных и социальных стереотипов.

Для науки это создает серьезный риск, ведь объективность исследования предполагает критическую дистанцию до источников и контекстов, с которыми работает исследователь. ИИ не осуществляет такого критического анализа — он воспроизводит те паттерны, которые статистически преобладают в учебных данных. В результате предотвращения не устраняются, а масштабируются и маскируются под нейтральность.

Алгоритмическое предубеждение проявляется не только теоретически, но и в вполне прикладных ситуациях. Например, языковые модели, обученные преимущественно на англоязычных научных базах данных, могут игнорировать специфику украинского законодательства, стандартов образования или локального экономического контекста.

В результате исследователю предлагаются «универсальные» методологические решения, которые могут оказаться непригодными или некорректными для украинской науки. Это особенно критично в областях, где контекст играет определяющую роль: праве, экономике, публичном управлении, педагогике. Таким образом, алгоритмическое предубеждение не только уродует результаты, но и создает иллюзию научной объективности там, где она методологически не обеспечена.

Эта проблема тесно связана с нестабильностью ответов. Выводы, сформулированные с помощью ИИ, могут существенно изменяться в зависимости от контекста запроса, формулировки вопроса или порядка представленных аргументов. Для научного исследования такая зависимость неприемлема, поскольку она подрывает постоянство аргументации.

Другими словами, ИИ:

Это означает, что текст может выглядеть убедительно в одном варианте, но терять логическую целостность после незначительных изменений контекста без объяснения причин такой трансформации.

В научной методологии проверяемость является ключевым условием валидности результатов. Исследователь может объяснить, почему именно был получен определенный вывод, и предоставить другим ученым возможность воспроизвести или критически оценить этот путь.

Результаты, сформированные с помощью ИИ, часто не соответствуют этому требованию. Из-за сочетания алгоритмического предубеждения, стохастической природы генерации и отсутствия прозрачного механизма принятия «решений» такие выводы сложно или невозможно проверить в классическом научном смысле.

В итоге возникает методологический парадокс: текст формально существует, аргументация дана, но научная проверка сводится к оценке формы, а не содержания. Для академической науки это означает потерю контроля за качеством знания, что принципиально неприемлемо — независимо от уровня технологического развития.

В научном исследовании человеческий фактор не вспомогательным, а определяющим элементом. Это связано с тем, что наука предполагает не только обработку информации, но и осознанное принятие решений, ответственность за интерпретацию результатов и готовность к публичной научной дискуссии.

Именно человеческий автор обеспечивает те компоненты, без которых исследование теряет эпистемологическую ценность.

Ключевые функции человеческого автора в научном исследовании

Эти функции не могут быть автоматизированы без потери научного содержания, поскольку они предполагают субъектность и рефлексию.

Человек vs ИИ: роль в научном познании

|

Критерий |

Человеческий автор |

ИИ |

|

Исследовательская позиция |

Формируется сознательно |

Отсутствует |

|

Ответственность за результаты |

Персональная |

Отсутствует |

|

Объяснение логики выводов |

Аргументировано |

Невозможно |

|

Участие в защите и дискуссии |

Активно |

Невозможно |

|

Эпистемологическая ценность |

Создается |

Не формируется |

Это сравнение ясно демонстрирует: ИИ может поддерживать исследователя технически, но не способен выполнять функцию автора.

Отдельное значение в научной деятельности имеют опыт и научная интуиция — факторы, не сводимые к алгоритмам. Они формируются постепенно и проявляются в способности исследователя:

Научная интуиция не является противоположностью рациональности, она является результатом накопленного знания и практики. Именно она позволяет создавать новое знание, а не только воспроизводить уже имеющееся.

В совокупности авторское мышление, ответственность, опыт и интуиция формируют то, что делает научное исследование методологически валидным и эпистемологически ценным. Ни одна автоматизированная система не может заменить этот комплекс без радикального упрощения самой науки.

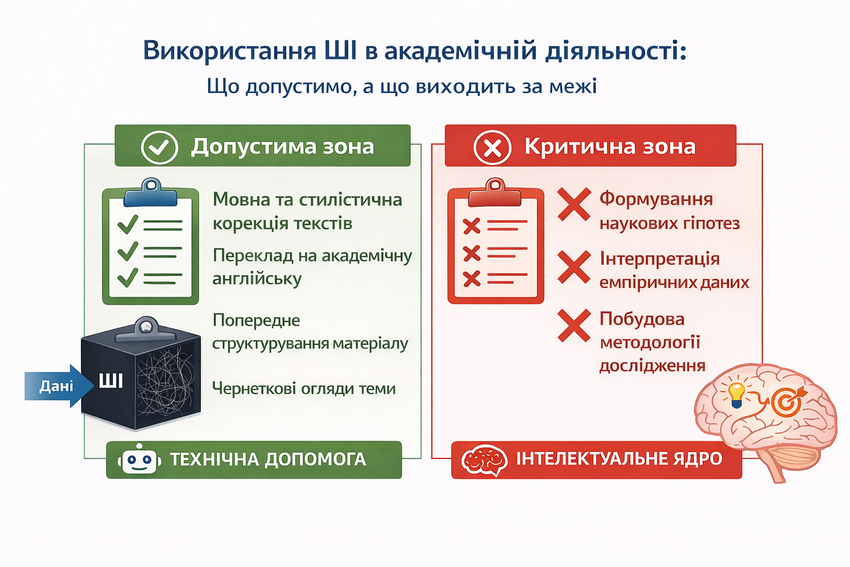

В современной научной практике искусственный интеллект целесообразно рассматривать не как автономный субъект исследования, а как технический инструмент, который может поддерживать отдельные этапы работы исследователя. Такой подход позволяет использовать потенциал ИИ без замены научного мышления автоматизированными решениями.

Ключевым вопросом является не сам факт применения ИИ, а контроль вне его использования. Когда алгоритм выполняет вспомогательные функции, он снижает когнитивную нагрузку и оптимизирует рабочие процессы. Когда ему делегируют формирование содержания, интерпретацию данных или построение аргументации, научное исследование теряет свою эпистемологическую ценность.

Именно поэтому в академической среде все более четко определяется разграничение между допустимым и проблемным использованием ИИ. Это разграничение не является технологичным, а методологическим.

|

Допустимые сценарии использования ИИ в науке |

Границы, которые не следует пересекать |

|

Языковая и стилистическая коррекция текстов |

Формирование научных гипотез |

|

Перевод на академический английский |

Интерпретация эмпирических данных |

|

Предварительное структурирование материала |

Построение методологии исследования |

|

Черновицкие обзоры темы |

Генерация аналитических отчетов |

|

Техническая помощь с формулировками |

Создание выводов без исследования |

Эта таблица демонстрирует принципиальную границу: ИИ может помогать с формой и организацией материала, но не может являться источником знания или автором исследовательских решений.

Совет для авторов: Используйте ИИ в качестве технического ассистента (корректора или переводчика), но никогда не доверяйте ему формулировку научной новизны

Переход этой границы имеет не только нравственные, но и практические последствия. Тексты, в которых ИИ используется для генерации содержания, быстро обнаруживаются при рецензировании из-за логических разрывов, нестабильности аргументации и отсутствия связи между методами и выводами. Даже при формальной корректности такие работы не выдерживают экспертную оценку.

В итоге эффективное использование ИИ в науке возможно только при сохранении авторского контроля над всеми ключевыми элементами исследования. Именно человеческий исследователь формирует смыслы, отвечает за результаты и обеспечивает научную валидность работы. В этом смысле искусственный интеллект полезен ровно настолько, насколько он остается инструментом, а не заменой ученого.

Попытки автоматизировать научную деятельность через использование искусственного интеллекта часто основываются на ложном предположении, что научную ценность можно масштабировать так же, как текстовую продукцию. Однако научное знание не результат вычисления, а формируется в процессе исследовательского мышления, критического анализа и ответственного выбора методов и интерпретаций.

Алгоритмы способны воспроизводить структуру, стиль и даже аргументацию, но они не создают эпистемологическую ценность — то есть новое, обоснованное знание. Именно поэтому автоматизированный текст может выглядеть научно корректным, но не выдерживать глубокую экспертную оценку. В науке масштабируются инструменты, но не масштабируется мышление.

В этом контексте будущее науки связано не с делегированием интеллектуальных функций алгоритмам, а с сотрудничеством между исследователем и технологиями. ИИ может снижать техническую нагрузку, ускорять отдельные процессы и помогать с формой подачи материала, однако ключевые этапы – постановка проблемы, работа с эмпирическими данными, интерпретация результатов и защита выводов – остаются сферой ответственности человека.

Именно из такого понимания научной деятельности следует «Дегри Сервис». В работе над научными статьями, монографиями и диссертациями компания делает акцент не на автоматизации, а на человеческой экспертизе, методологической корректности и авторской ответственности. Все научные работы готовятся реальными специалистами по опыту исследовательской деятельности, с учетом требований специальностей, академических стандартов и процедур рецензирования.

В результате технологии могут быть полезными инструментами в науке, но только при условии, что они не подменяют сам процесс познания. Научный результат остается ценным ровно настолько, насколько за ним стоит мышление, опыт и ответственность автора, а не методическая имитация этих составляющих.